Информация

Информация — понятие, обозначающее упорядоченность материи в составе вещей, а также сведения об этой упорядоченности[1]. Информация всегда имеет определённый формат кодирования и материальный носитель[2][3].

Слово «информация» происходит от латинского корня forma, обозначающего пространственную форму, вид, фигуру, образ, облик, очертание, рисунок, внешность, характер, состояние, устройство, проект некоторого предмета. Более близкое in-formo (лат.) значит придавать форму, формировать, создавать, устраивать, организовывать, строить, мыслить, соображать; in-formatio (лат.) — разъяснение, изложение, истолковывание, представление, понятие, осведомление, просвещение[4].

Определения

Есть два подхода к определению информации[5]:

- В «функциональном» подходе информация понимается как отражение упорядоченности (структуры, свойств) одних предметов в упорядоченности других[6]. В этом подходе информация есть отличительное свойство живых организмов, обусловленное психическим отражением внешнего мира, а также способностью организмов к осмысленному и целенаправленному поведению[7].

- В «аттрибутивном» подходе информация есть общеприродная категория наряду с материей, энергией и временем[8]. В этом случае информация рассматривается как объективные состояния и свойства, упорядоченность материи в живой и неживой природе[9][10].

Более конкретные определения разработаны в кибернетике для моделирования общих закономерностей управления. При этом многогранность информации в технических устройствах, биологических и социальных системах, статистической и квантовой физике обуславливает разнообразие существующих формулировок[5][11][12][13][14]. Наиболее распространённые подходы определяют информацию как

- упорядоченность и организацию системы (например, упорядоченность букв в слове или оснований в ДНК)[15]; отражённое разнообразие (например, неоднородность распределения материи в пространстве)[16]

- содержание, полученное системой из внешнего мира в процессах приспособления и управления[17]; сведения о системе, о её структуре и функции, выраженные моделью[18]; сведения и знания о предметах и событиях, отражение предметов в психике субъекта и технических устройствах[19]

- значимое различие (например, это — не это)[20]; случайный запомненный выбор одного из нескольких вариантов[11][21], а также процесс его последующего использования[2].

Некоторые исследователи придерживаются мнения, что информация (наравне с материей, пространством и временем) относится к базовым неопределяемым понятиям науки[5].

Исторические вехи

Донаучный период

В традиционных культурах информационные, то есть нематериальные понятия, такие как сознание, разум, совесть, Бог, правда и т. д., относятся к духовной стороне жизни[23]. При этом сознание и душа соответствуют современному понятию «психика» (греч. psyche)[24][25][26].

В донаучный период информация-душа считалась неотъемлемой частью природы. Вопреки расхожему отождествлению атомизма и материализма, в учениях античных атомистов атомы являются единицами не только материи, но и души. Согласно Левкиппу, Демокриту, Эпикуру, например, атомы души (сферической формы и сравнительно малого размера) присутствуют во всех предметах, так что вся материя в большей или меньшей мере одушевлена[24].

На неотделимость информации-образа от предметов указывает русская поговорка[23] (стр. 633):

Нет вещи без образа.Русская поговорка

Выделение информации в отдельную сферу бытия осуществлено платоновской школой античных философов. Согласно Платону, параллельно с «материальным» миром зримых вещей существует мир образов-представлений (idea, идея) и абстрактных образов-форм (eidos, эйдос). Этот идеальный мир (мир идей, то есть информационный, духовный мир) первичен по отношению к «материальной» (неидеальной) реальности[22]. У Аристотеля информация-форма является одним из основных принципов бытия наряду с материей, причиной и целью[13].

Европейский материализм

Отделение материи от информации зафиксировано Р. Декартом. В его терминологии информация соответствует идеальному, мыслимому миру (res cogitas), основным свойством которого является неделимость, тогда как материя соответствует внешнему миру (res extensa), основным свойством которого является протяжённость в пространстве. В человеке это разделение соответствуют телу и духу, причём духовная (информационная) сторона жизни относится Декартом к сфере религии и считается недоступной для научного изучения[25].

Следуя Декарту, европейская наука 17-19 веков вопросами информатики практически не занимались. Утвердился механистический взгляд на человека как на сложную машину, действие которой предопределено законами механики и химии. Ограниченность такой философии[27][28] описал русский поэт Ф. И. Тютчев[29]:

Не то, что мните вы, природа:

Не слепок, не бездушный лик -

В ней есть душа, в ней есть свобода,

В ней есть любовь, в ней есть язык...Ф.И. Тютчев, 1836 год

В 1848 году в Западной Европе разработана и получила распространение философия марксизма, исключающая из рассмотрения информацию (душу и дух) и сводящая поведение человека к действию биологических и экономических факторов[30].

Ленинская редакция марксизма стала основой философии в СССР. Широко обсуждая объективно существующие формы бытия, формы движения материи, формы вещества и восприятия, а также информационные процессы отображения (переноса образов), само понятие информации — формы в Ленинском списке фундаментальных категорий природы отсутствует[31]:

В мире нет ничего, кроме движущейся материи,

и движущаяся материя не может двигаться иначе,

как в пространстве и времени.В.И. Ленин, 1909 год

По отношению к основополагающим «материальным» факторам, информационной стороне природы таким образом отводится вторичное место («бытие определяет сознание»).

Открытия квантовой физики

В 20 веке информатика получила новое развитие в связи с открытием квантовой механики. Оказалось, что важнейшие явления природы, в том числе само существование атомов, в рамках классической физики объяснить невозможно. Для этого пришлось ввести понятие волновой функции, или квантового состояния частиц, определяющей вероятности наблюдаемых событий, например, форму распределения частиц на экране в эксперименте по двухщелевой интерференции Юнга[32]. Будучи функцией в многомерном векторном пространстве, эта новая сущность не является ни материальной, ни энергетической, ни пространственно-временной. Это свойство относит квантовое состояние к объектам информационного типа[33][34][35].

Не сводимая к свойствам материи информационная природа квантового состояния делает информацию центральным понятием квантовой физики[36][37]. В силу того, что квантовая механика является одной из наиболее фундаментальных физических теорий, этот вывод ведёт к коренному пересмотру места информации в природе, продолжающемуся в настоящее время[38][39][40][41][42][43].

Грани информации

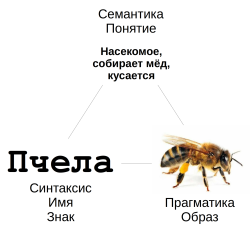

В любой информации присутствует три аспекта[45]

- Синтаксический, описывающий знаковое выражение информации в некоторой кодировке или языке;

- Семантический, описывающий смысл или значение информации для воспринимающего её субъекта;

- Прагматический, описывающий цель использования информации субъектом, его практическое назначение и результат.

С некоторыми особенностями эти аспекты образуют модель знака, то есть информационной единицы в классической и прикладной семиотике, образуя т. н. треугольник Фреге[46]. В прикладной семиотике[44] вершине «синтаксис» соответствует имя знака, например русское слово «пчела». Вершине «семантика» соответствует понятие пчелы, в том числе совокупность её свойств (насекомое, собирает мёд, кусается и так далее). Вершине «прагматика» соответствует образ пчелы и связанных с ней действий.

Измерение количества информации

Синтаксический аспект

Количество синтаксической информации в некотором наборе данных определяется использованным форматом кодирования (речь, азбука Морзе, пространственные координаты, jpg, mp3 и т. д.). Такая кодировка фиксирует набор доступных символов-знаков[47]. В современном русском языке, например, таковыми являются 33 буквы алфавита.

В наиболее распространённом (вероятностном)[48][49] подходе количество синтаксической информации измеряется в битах. При этом информация, содержащаяся в символе такого алфавита определяется как двоичный логарифм от обратной вероятности его встречаемости в этом алфавите:

Согласно этой формуле в двоичном алфавите {0,1} при вероятности использования обоих символов имеем , то есть один двоичный символ содержит 1 бит информации.

Если все символы алфавита длиной используются одинаково часто, то вероятность обнаружения каждого символа и согласно предыдущей формуле его информативность есть

Эта величина (с точностью до постоянной Больцмана) равна энтропии макросостояния с равновероятными микросостояниями[50][51]. В связи с другим типом неопределённости в квантовых системах, для измерения соответствующего количества информации представленные выражения должны быть модифицированы[52].

Семантический аспект

Семантический (смысловой) аспект информации труден для формализации из-за его субъективности[53][54][55][56]: одно и то же сообщение, например, «следующий поезд отправляется в 12 часов» для разных читателей может иметь совершенно разный смысл: кто-то будет обрадуется скорой поездке, кто-то обеспокоится из-за необходимости собираться, а кто-то и вовсе не поймёт, о каком поезде идёт речь. В этой связи общепринятого способа представления семантической информации, равно как и измерения её количества, в настоящее время не существует.

Одним из наиболее разработанных методов кодирования (эмоционального) смысла[57] информации является её размещение в трёхмерном семантическом пространстве, образованном осями оценка (E), сила (P) и активность (A). Каждая из этих величин измеряется действительным числом, а все три числа вместе представляют координату любого информационного блока в трёхмерном семантическом пространстве[58][59]. Например, слово «быстрый» в этом пространстве будет расположено вблизи точки со следующими координатами: умеренно положительная оценка Е, нейтральная сила P и высокая активность A. Пространственные модели смысла используются в академической, социальной и политической психологии[60][61][62].

Прагматический аспект

Прагматический (практический) аспект информации ещё более труден для формализации вследствие того, что цели субъекта гораздо более разнообразны, чем эмоционально-смысловые оценки получаемой информации[63][64][65]. В этой связи семантика и прагматика зачастую игнорируются, что обуславливает тенденцию к сужению понятия информации до синтаксического аспекта[66]. Тем не менее и для прагматической информации существуют математические представления и меры количества на основе классической и квантовой теорий вероятности[11][67][68][69].

Информация в природе

Информация, материя и вычисление

Любая информация существует на некотором материальном носителе, также как и любая материя имеет некоторый информационный образ. При этом одна и та же материя может принимать различные информационные состояния, и наоборот, одна и та же информация может быть размещена на различных материальных носителях[10]. Информация неотделима от материи, но и не сводится к ней[2][8][70], как отмечено в том числе основоположником кибернетики Н. Винером[15]:

Информация — это не материя и не энергия,

информация — это информация.

Тот материализм, который не признает этого,

не может быть эффективен в настоящее время.Н. Винер, 1968 год

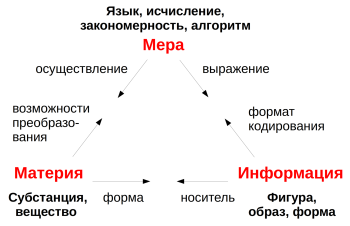

В информационной перспективе Вселенная может рассматриваться как колоссальный компьютер, в котором законы физики, химии, биологии, психологии и др. представляют собой естественные алгоритмы преобразования информации в природе на разных уровнях сложности и пространственно-временных масштабах[71][72]. В системе Аристотеля (материя, форма, причины и цели, раздел «Донаучные период») эти закономерности соответствуют причинам (объективным предпосылкам) и целям (субъективным намерениям). В этой связи мир рассматривается как триединство материи (вещества, субстанции), образов (информации, форм) и меры (закономерностей и алгоритмов, то есть возможных вариантов преобразования материи)[73]. Мерой, например, в компьютере являются управляющие его работой физические законы (электричество и магнетизм, физика полупроводников и т. д.) а также установленные программы и алгоритмы (операционная система, языки программирования, редакторы, браузеры, игры и т. д.), определяющие возможные способы работы на компьютере.

Информация в управлении

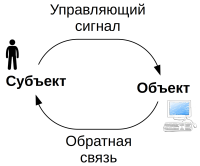

В буквальном прочтении ин-формация есть оформление, то есть процесс наделения предметов некоторым образом-формой (свойством), приведение их в некоторое состояние[2][66][74]. Этот процесс есть процесс управления объектом. Необходимая для этого информация (как существительное) может передаваться, например, в виде печатного или устного слова, видеоролика или радиосообщения (например, при дистанционном управлении движением робота)[15]. В этой связи управление по существу состоит в передаче информации от субъекта к объекту, вследствие чего информация является центральным понятием кибернетики как науки об управлении[5][15][75][76]. При взаимодействии человека с машиной (компьютером) человек подаёт машине управляющую информацию (печатные или голосовые команды, клики мыши и т. д.) и получает ответную информацию в виде образов на экране, звуков и т. д.

Информация в сложных системах

Понятие информации широко используется для описания сложных систем: технических, биологических, социальных и др.[11][74][77][78][79]. Примером сложной системы является компьютер, «поведение» которого состоит в динамике изображений на экране. В этом случае понятия информации, форматов кодирования и структур данных, программы и алгоритма, операционной системы и т. д. позволяют объяснить происходящее на экране значительно проще, чем на основе физики полупроводников и закона Ома, непосредственно определяющих движение электрических зарядов в процессоре. Высокоуровневые информационные закономерности позволяют моделировать процессы и явления, детальное описание которых не представляется возможным: самоорганизацию и возникновение сложности[11][77], мышление и сознание[3][26], приближая науку к пониманию феномена жизни[7][10][80][81][82][83][84].

Информация в живых организмах

Информация занимает главное место в управлении поведением человека и других живых организмов. Естественная система такого управления называется когнитивной системой или психикой организма[15][75][26]. Материальным носителем психики является тело и нервная система организма, включая головной мозг. В компьютерной метафоре телу и психике соответствует аппаратное и программно-информационное обеспечение. Живые организмы, однако, отличаются от алгоритмических систем наличием субъектности, то есть способности к свободному и творческому действию[53][54][85].

В психику человека поступает порядка 10 миллионов бит информации в секунду, из которых около 90 % приходится на зрение[86]. Большая часть этой информации (в том числе управление клеточным гомеостазом, пищеварением, ритмами мозга, ходьбой и ездой на велосипеде и т. п.) обрабатывается в автоматическом режиме без сознательного контроля[87]. Информация при этом представляется в различных кодировках, наиболее высокоуровневые из которых переживаются как эмоции, чувства, понятия, мысли, образы, воспоминания и т. д.[14][26][88]. На низком уровне информация кодируется в виде отдельных нейронных возбуждений, гормонов, нейромедиаторов и других химических соединений[89].

Создание информации

В процессах копирования, передачи и вычисления информация может теряться (например, из двух чисел можно получить их сумму, но из суммы восстановить слагаемые нельзя), однако новая информация возникать не может[90]. Это относится в том числе к алгоритмам фотографирования, распознавания и классификации, искусственному интеллекту любой сложности и другим алгоритмическим системам[85].

Часто говорят, что вычислительная машина производит новую информацию.

Это в действительности не так. Машины могут обрабатывать информацию:

они берут сырой материал и выдают законченный продукт,

но общее количество информации не возрастает.Л. Бриллюэн, Наука и теория информации (стр. 346), 1960 год

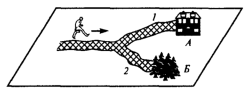

Как явно указано в одном из определений (случайный запомненный выбор[11][21]), источником информации может быть только случайный выбор, то есть выбор, не предопределённый никаким алгоритмом. Истинная случайность имеет место в поведении живых организмов[10], например, при свободном выборе одной из двух дорог на развилке[2]. Согласно формуле выше, при этом создаётся один новый бит информации.

Также истинно случайным является результат разрешения квантовой неопределённости. На этом свойстве основаны квантовые генераторы случайных чисел, используемые в том числе в криптографии для создания ключей шифрования. В отличие от встроенных во многие языки программирования генераторов псевдо-случайных чисел (на самом деле получаемых при помощи алгоритмов и не являющихся случайными), квантовая случайность обеспечена фундаментальными законами природы[91][92].

Примечания

- ↑ Информация. Большая Советская Энциклопедия. Дата обращения: 24 мая 2023.

- ↑ 2,0 2,1 2,2 2,3 2,4 2,5 Мелик-Гайказян И. В. Информационные процессы и реальность. — М.: Наука, 1998.

- ↑ 3,0 3,1 Дубровский Д. И. Информация, сознание, мозг. — М.: Высшая школа, 1980. — 286 с.

- ↑ Дворецкий И. Х. Латинско-русский словарь. — М.: Русский язык, 1976. — 1096 с.

- ↑ 5,0 5,1 5,2 5,3 Юсупов Р. М. К семидесятилетию отечественной информатики // Труды СПИИРАН. — 2019. — Т. 18, № 1. — С. 5—29.

- ↑ Физическая энциклопедия. Том 2 / Прохоров А. М.. — М.: Наука, 1990. — С. 176.

- ↑ 7,0 7,1 Моисеев Н. Н. Человек и ноосфера. — М.: Молодая гвардия, 1990. — 351 с.

- ↑ 8,0 8,1 Коротков Н. А. Что есть информация? // Вестник Ленинградского государственного университета им. А. С. Пушкина. — 2012. — Т. 2, № 3. — С. 60—68.

- ↑ Гуревич И. М. Урсул А. Д. Информация - всеобщее свойство материи. Характеристики, оценки, ограничения, следствия. — М.: УРСС, 2015. — С. 312.

- ↑ 10,0 10,1 10,2 10,3 Корогодин В. И., Корогодина В. Л. Информация как основа жизни. — Дубна: Издательский центр «Феникс», 2000. — 208 с.

- ↑ 11,0 11,1 11,2 11,3 11,4 11,5 Чернавский Д. С. Синергетика и информация. — М.: Наука, 2001.

- ↑ Максимов Н. В. Лебедев А. А. О природе и определениях информации: физика и семантика // Научно-Техническая Информация. Серия 2: Информационные Процессы И Системы. — 2020. — № 7. — С. 1—12.

- ↑ 13,0 13,1 Курилкина В. Н. Философский и общенаучный анализ понятия информации // Философские науки : журнал. — 2014. — Т. 11, № 1. — С. 73—77.

- ↑ 14,0 14,1 Кузнецов Н. А., Баксанский О. Е., Гречишкина Н. А. Фундаментальное значение информатики в современной научной картине мира // Информационные процессы. — 2006. — Т. 6, № 2. — С. 81—109.

- ↑ 15,0 15,1 15,2 15,3 15,4 Винер Н. Кибернетика или управление и связь в животном и машине. — М.: Советское радио, 1968.

- ↑ Урсул А. Д. Информация и мышление. — М.: Знание, 1970. — С. 48.

- ↑ Винер Н. Кибернетика и общество. — М.: Издательство иностранной литературы, 1958.

- ↑ Амосов Н. М. Моделирование сложных систем. — Киев: Наукова думка, 1968.

- ↑ Система стандартов по информации, библиотечному и издательскому делу // ГОСТ Р 7.0-99. — 2000.

- ↑ Bateson G. Form, Substance, and Difference // Steps to an ecology of mind. — 1972.

- ↑ 21,0 21,1 Кастлер Г. Возникновение биологической организации. — М.: Мир, 1967.

- ↑ 22,0 22,1 Платон. Собр. соч. в 4-х томах. Том 3: Тимей. — М.: Мысль, 1994.

- ↑ 23,0 23,1 Даль В.И. Толковый словарь живого великорусского языка. — СПб.: Издание книгопродавца-типографа М. О. Вольфа, 1881.

- ↑ 24,0 24,1 Bailey C. The Greek Atomists and Epicurus. — Oxford at the Сlarendon Press, 1928.

- ↑ 25,0 25,1 Чикин А. Проблема психофизического дуализма в философии Рене Декарта и схоластическая традиция // Труды Нижегородской духовной семинарии. — 2016. — С. 323—386.

- ↑ 26,0 26,1 26,2 26,3 Налимов В. В. Спонтанность сознания: вероятностная архитектура смыслов и смысловая архитектоника личности. — М.: Прометей, 1989. — 288 с.

- ↑ Гуссерль Э. Кризис европейского человечества и философия // Вопросы философии. — 1986. — № 3. — С. 101—116.

- ↑ Kauffman S. A., Gare A. Beyond Descartes and Newton: Recovering life and humanity // Progress in Biophysics and Molecular Biology. — 2015. — Т. 119, № 3. — С. 219—244.

- ↑ Ф.И. Тютчев. Не то, что мните вы, природа... (1836 г.).

- ↑ Энгельс Ф. Анти-Дюринг. — М.: Издательство политической литературы, 1988.

- ↑ Ленин В. И. Материализм и эмпириокритицизм. — М.: Издательство политической литературы, 1986.

- ↑ Фейнман Р. Лейтон Р. Сэндс М. Фейнмановские лекции по физике. Том 8. — М.: Мир, 1966.

- ↑ Hiley B. J. From the Heisenberg Picture to Bohm: a New Perspective on Active Information and its relation to Shannon Information / Хренников А. Ю. — Växjö University Press, 2002. — С. 141—162.

- ↑ Гуц А. К. Основы квантовой кибернетики. — Омск: Полиграфический центр КАН, 2008. — 204 с.

- ↑ Хренников А. Ю. Введение в квантовую теорию информации. — М.: Физматлит, 2008. — 284 с.

- ↑ Wheeler J. A. Information, Physics, Quantum: The Search for Links // 3rd Int. Symp. Foundations of Quantum Mechanichs. — 1989. — С. 3—28.

- ↑ Zeilinger A. A Foundational Principle for Quantum Mechanics // Foundations of Physics. — 1999. — Т. 29, № 4. — С. 631—643.

- ↑ Эрекаев В. Д. Современная философия и квантовая физика. Аналитический обзор. — М.: ИНИОН РАН, 2007. — С. 110.

- ↑ Davies P., Gregersen N. H. Information and the nature of reality: From physics to metaphysics. — Cambridge University Press, 2010. — С. 382.

- ↑ Healey R. The Quantum Revolution in Philosophy. — Oxford University Press, 2017.

- ↑ Копейкин К. В. «Души» атомов и «атомы» души: Вольфганг Эрнст Паули, Карл Густав Юнг и «три великих проблемы физики» // Успехи физических наук. — 1991.

- ↑ Widdows D., Bruza P. Quantum Information Dynamics and Open World Science // AAAI Spring Symposium: Quantum Interaction. — 2007.

- ↑ Asano M., Basieva I., Khrennikov A. Yu., Ohya M., Tanaka Y., Yamato I. Quantum Information Biology: From Information Interpretation of Quantum Mechanics to Applications in Molecular Biology and Cognitive Psychology // Foundations of Physics. — 2015. — Т. 45, № 10. — С. 1362—1378.

- ↑ 44,0 44,1 Поспелов Д. А. Осипов Г. С. Прикладная семиотика. — 2000.

- ↑ Foundations of the Theory of Signs // International encyclopedia of unified science. — Chicago University Press, 1938. — С. 77—137.

- ↑ Фреге Г. О смысле и значении // Логика и логическая семантика. Сборник трудов. — М.: Аспект Пресс, 2000. — С. 230—246.

- ↑ Верещагин Н. К., Щепин Е. В. Информация, кодирование и предсказание. — М.: ФМОП МЦНМО, 2012. — 236 с.

- ↑ Колмогоров А. Н. Три подхода к определению понятия "количество информации" // Проблемы передачи информации. — 1965. — Т. 1, № 1. — С. 3—11.

- ↑ Колмогоров А. Н. Теория информации и теория алгоритмов. — М.: Наука, 1987. — 304 с.

- ↑ Brillouin L. The Negentropy Principle of Information // Journal of Applied Physics. — 1953. — Т. 24, № 9. — С. 1152—1163.

- ↑ Кадомцев Б. Б. Динамика и информация // Успехи Физических Наук. — 1994. — Т. 164, № 5. — С. 449—530.

- ↑ Brukner Č. Zeilinger A. Conceptual inadequacy of the Shannon information in quantum measurements // Physical Review A - Atomic, Molecular, and Optical Physics. — 2001. — Т. 63, № 2.

- ↑ 53,0 53,1 Брушлинский А. В. Субъект: мышление, учение, воображение. — М.: Институт практической психологии, 1996. — 392 с.

- ↑ 54,0 54,1 von Uexküll J. A stroll through the worlds of animals and men: A picture book of invisible worlds // Semiotica. — 1992. — Т. 89, № 4. — С. 319—391.

- ↑ Samsonovich A. V., Goldin R. F., Ascoli G. A. Toward a semantic general theory of everything // Complexity. — 2009. — Т. 16, № 4. — С. 12—18.

- ↑ Weber A. The Book of Desire: Toward a Biological Poetics // Biosemiotics. — 2011. — Т. 4, № 2. — С. 149—170.

- ↑ Peil K. T. Emotion: the Self-regulatory Sense // Global Advances in Health and Medicine. — 2014. — Т. 3, № 2. — С. 80—108.

- ↑ Osgood C. E. The nature and measurement of meaning // Psychological Bulletin. — 1952. — Т. 49, № 3. — С. 197—237.

- ↑ Osgood C. E. On the whys and wherefores of E, P, and A // Journal of Personality and Social Psychology. — 1969. — Т. 12, № 3. — С. 194—199.

- ↑ Gärdenfors P. Geometry of Meaning. Semantics based on conceptual spaces. — Cambridge: MIT Press, 2014.

- ↑ Петренко В. Ф. Психосемантика сознания. — М.: Издательство Московского Университета, 1988. — 208 с.

- ↑ Петренко В. Ф., Митина О. В. Политическая психология. Психосемантический подход. — Москва, Челябинск: Социум, 2018. — 592 с.

- ↑ Кузнецов Н. А., Баксанский О. Е., Жолков С. Ю. Истоки и основания прагматического знания // Информационные процессы. — 2011. — Т. 11, № 4. — С. 428—447.

- ↑ Gernert D. Pragmatic information: Historical exposition and general overview // Mind and Matter. — 2006. — Т. 4, № 2. — С. 141—167.

- ↑ Semantics versus Pragmatics / Szabo Z. G. — Oxford University Press, 2015.

- ↑ 66,0 66,1 Markoš A., Cvrčková F. The Meaning(s) of Information, Code ... and Meaning // Biosemiotics. — 2013. — Т. 6, № 1. — С. 61—75.

- ↑ Харкевич А. А. О ценности информации // Проблемы кибернетики. — 1960. — Т. 4, № 4. — С. 53—57.

- ↑ Суров И. А. Какая разница? Прагматическая формализация смысла // Искусственный интеллект и принятие решений. — 2023. — № 1. — С. 78—89.

- ↑ beim Graben P. Pragmatic information in dynamic semantics // Mind and Matter. — 2006. — Т. 4, № 2. — С. 169—193.

- ↑ Волченков Е. Я. Компьютинг и информация (онтологический аспект) // Научно-техническая информация. Серия 2. Информационные процессы и системы. — 2009. — № 1. — С. 12—16.

- ↑ Wheeler J. A. The computer and the universe // International Journal of Theoretical Physics. — 1982. — Т. 21, № 6—7. — С. 557—572.

- ↑ Ллойд С. Программируя Вселенную. Квантовый компьютер и будущее науки. — Альпина Диджитал, 2013. — 300 с.

- ↑ Щеголькова Д. В., Орешкина Е. И. Вопрос состоятельности принципа триединства «Материя - информация - мера» // Актуальные проблемы авиации и космонавтики. — 2012. — № 8. — С. 455—456.

- ↑ 74,0 74,1 Мелик-Гайказян И. В. Методология моделирования взаимосвязей необратимости, сложности и информационных процессов // Бюллетень сибирской медицины. — 2006. — Т. 5, № 5. — С. 101—114.

- ↑ 75,0 75,1 Брушлинский А. В. Психология мышления и кибернетика. — М.: Мысль, 1970.

- ↑ Новиков Д. А. Кибернетика (навигатор). — М.: Ленанд, 2015. — 160 с.

- ↑ 77,0 77,1 Хакен Г. Информация и самоорганизация. Макроскопический подход к сложным системам. — М.: УРСС, 2014. — 320 с.

- ↑ Гижа А. В. Понятие информации, содержательности и смысла: что лежит в основе информационного общества? // Философская Мысль. — 2017. — Т. 4, № 4. — С. 13—21.

- ↑ Хренников А. Ю., Watanabe N. Order-stability in complex biological, social, and ai-systems from quantum information theory // Entropy. — 2021. — Т. 23, № 3.

- ↑ Walker S. I., Davies P. C. W. The algorithmic origins of life // Journal of The Royal Society Interface. — 2013. — Т. 10, № 79.

- ↑ Gershenson C. The World as Evolving Information // Unifying Themes in Complex Systems VII. — Berlin: Springer, 2012. — С. 100—115.

- ↑ Towards a semiotic biology. Life is the Action of Signs / Emmeche C., Kull K.. — Imperial College Press, 2011. — 304 с.

- ↑ Моисеев Н. Н. Алгоритмы развития. — М.: Наука, 1987. — 304 с.

- ↑ From Matter to Life. Information and Causality / Walker S. I. Davies P. C. W. Ellis G. F. R.. — Cambridge University Press, 2017. — 494 с.

- ↑ 85,0 85,1 Барышников П. Н. Компьютерные метафоры в теориях сознания // Философские проблемы информационных технологий и киберпространства. — 2011. — № 2. — С. 24—36.

- ↑ Zimmermann M. The Nervous System in the Context of Information Theory // Human Physiology / Schmidt R. F., Thews G. — Berlin: Springer, 1989. — С. 166—173.

- ↑ Норретрандерс Т. Иллюзия пользователя. Урезание сознания в размерах. — М.: Викинг, 1999.

- ↑ Вартанов А. В. Сознание и мозг – информационный подход // Актуальные вопросы нейрофилософии - 2015. Ежегодник. Материалы международного междисциплинарного семинара "Нейрофилософия". — 2016.

- ↑ Barbieri M. Code Biology. A new science of life. — Cham: Springer, 2015.

- ↑ Бриллюэн Л. Наука и теория информации. — М.: Государственное Издательство Физико-Математической Литературы, 1960. — 392 с.

- ↑ Zeilinger A. The message of the quantum // Nature. — 2005. — Т. 438, № 7069.

- ↑ Jaeger G. Quantum randomness and unpredictability // Fortschritte der Physik. — 2017. — Т. 65, № 6—8.

Данная статья имеет статус «готовой». Это не говорит о качестве статьи, однако в ней уже в достаточной степени раскрыта основная тема. Если вы хотите улучшить статью — правьте смело! |